ChatGPT suscite enthousiasme et crainte depuis son lancement en novembre 2022. Sa maîtrise apparente de la sémantique et de la syntaxe – mais pas encore du contenu – de différentes langues surprend les utilisateurs qui s’attendent à un chatbot ordinaire. Certaines universités ont immédiatement interdit aux étudiants d’utiliser ChatGPT pour rédiger des dissertations, car il est plus performant que la plupart des étudiants humains. Les journaux ont annoncé la fin de l’éducation, non seulement parce que les étudiants peuvent l’utiliser pour faire leurs devoirs, mais aussi parce que ChatGPT peut fournir plus d’informations que de nombreux enseignants. L’intelligence artificielle semble avoir conquis un autre domaine qui, selon la philosophie classique, définit la nature humaine : le logos. La panique grandit avec cette nouvelle perte de territoire existentiel. L’imagination apocalyptique de l’histoire humaine s’intensifie à mesure que l’effondrement du climat et la révolte des robots évoquent la fin des temps.

La fin des temps n’était pas étrangère aux modernes. En effet, dans son ouvrage de 1949 intitulé Histoire et salut, Karl Löwith a montré que la philosophie moderne de l’histoire, de Hegel à Burckhardt, était une sécularisation de l’eschatologie[1]. Le telos de l’histoire est ce qui rend immanent le transcendant, qu’il s’agisse de la seconde venue de Jésus-Christ ou simplement du devenir de l’Homo deus. Cet imaginaire biblique ou abrahamique du temps offre de nombreuses et profondes réflexions sur l’existence humaine en général, mais s’oppose aussi à la compréhension de notre avenir.

Dans les années 1960, Hans Blumenberg s’est opposé à la thèse de la sécularisation de Löwith, ainsi qu’à l’affirmation de Carl Schmitt selon laquelle « tous les concepts importants de la théorie moderne de l’État sont des concepts théologiques sécularisés »[2]. Blumenberg soutient que la compréhension de la modernité comme la sécularisation ou la transposition de concepts théologiques sape la légitimité de la modernité ; une certaine signification de la modernité reste irréductible à la sécularisation de la théologie[3]. De même, la nouveauté et l’importance de l’intelligence artificielle sont enterrées par l’imaginaire eschatologique, par les stéréotypes modernes des machines et par la propagande industrielle.

Cela ne veut pas dire que nous devrions nier le changement climatique et résister à l’intelligence artificielle. Au contraire, la lutte contre le changement climatique devrait être notre priorité absolue, tout comme le développement d’une relation productive entre les humains et la technologie. Mais pour ce faire, nous devons développer une compréhension adéquate de l’intelligence artificielle, au-delà d’une compréhension purement technique. L’invention du train, de l’automobile et, plus tard, de l’avion a également suscité de grandes craintes, tant sur le plan psychologique qu’économique, mais aujourd’hui, rares sont ceux qui craignent que ces machines échappent à notre contrôle. Au contraire, les voitures et les avions font partie de la vie quotidienne et sont souvent synonymes d’excitation et de liberté. Alors pourquoi l’intelligence artificielle suscite-t-elle tant de craintes ?

Pour comprendre cette nouvelle vague technologique, dont ChatGPT est le fer de lance, nous pouvons commencer par la célèbre expérience de pensée de John Searle dans la Chambre chinoise en 1980, qui dissimule le stéréotype le plus ennuyeux des machines informatiques sous l’apparence d’un raisonnement logique. Dans cette expérience de pensée, Searle s’imaginait seul dans une pièce, chargé de suivre des instructions selon un programme de traitement de symboles écrit en anglais, afin de répondre à des entrées écrites en chinois et glissées sous la porte. Dans cette expérience, Searle ne comprend pas le chinois : « Je ne connais pas le chinois, qu’il soit écrit ou parlé, et je ne suis même pas sûr de pouvoir reconnaître l’écriture chinoise comme une écriture chinoise distincte, par exemple, de l’écriture japonaise ou de gribouillis sans signification »[4]. Cependant, il affirme qu’avec les bonnes instructions et les bonnes règles, il pourrait répondre d’une manière qui amènerait la personne à l’extérieur de la pièce à croire qu’il comprend le chinois. En d’autres termes, Searle affirme que ce n’est pas parce qu’une machine est capable de suivre des instructions en chinois qu’elle comprend le chinois, ce qui est la caractéristique de l’IA dite forte (par opposition à l’IA faible). Comprendre, c’est d’abord comprendre la sémantique. Alors que la syntaxe peut être codée en dur, la signification sémantique change en fonction de la situation et des circonstances. La Chambre chinoise de Searle s’applique à un ordinateur fonctionnant encore comme une machine du dix-huitième siècle, comme le ferait le Canard de Vaucanson ou le Turc mécanique. Cependant, ce n’est pas le type de machine auquel nous avons affaire aujourd’hui. Noam Chomsky, Ian Roberts et Jeffrey Watumull avaient raison d’affirmer que ChatGPT est « un moteur statistique lourd pour le filtrage par motif »[5]. Cependant, nous devons reconnaître que, bien que les modèles soient une caractéristique principale de l’information, ChatGPT fait plus que de la simple recherche de modèles.

Une telle critique syntaxique repose sur une épistémologie mécaniste qui suppose une causalité linéaire – une cause suivie d’un effet. On peut inverser ce processus de cause à effet pour atteindre la cause ultime : le moteur premier, le défaut de la cause première et le destin ultime de tout raisonnement linéaire. À l’opposé de la causalité linéaire et de la philosophie mécaniste, le dix-huitième siècle a vu l’essor d’une pensée philosophique fondée sur l’organisme, dont la Critique de la faculté de juger d’Emmanuel Kant est l’une des contributions les plus significatives. Comme je l’ai déjà dit, Kant a imposé une nouvelle condition pour philosopher, à savoir que la philosophie doit devenir organique ; en d’autres termes, l’organique a marqué un nouveau départ pour la pensée philosophique[6]. Aujourd’hui, il est important de reconnaître que la condition de philosopher établie par Kant a pris fin avec la cybernétique[7].

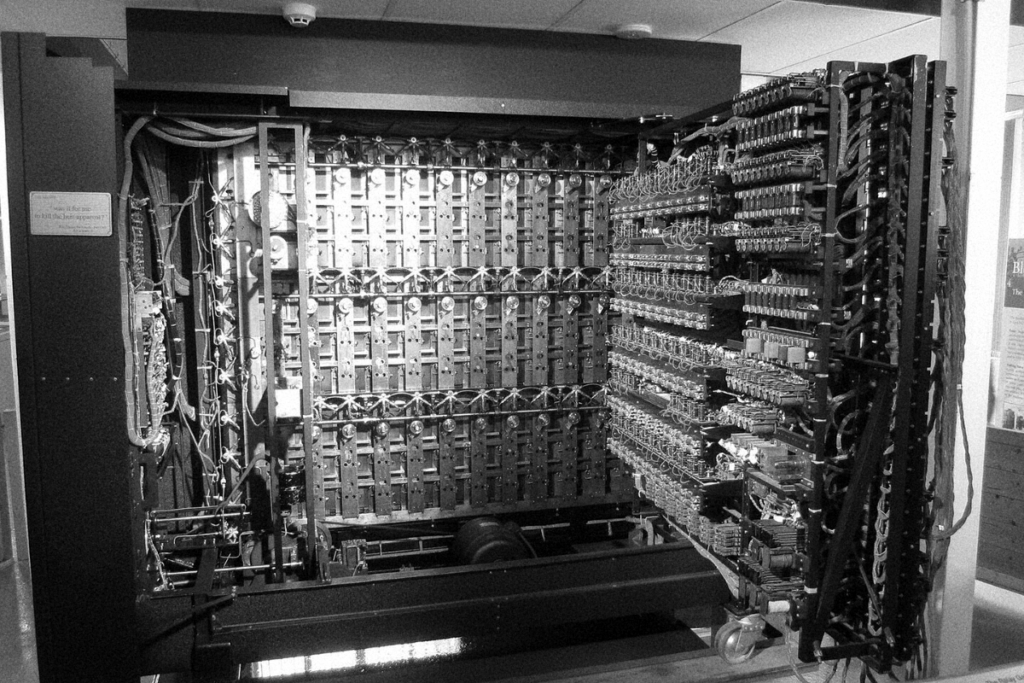

La cybernétique, terme inventé par Norbert Wiener vers 1943, a été développée par un groupe de scientifiques et d’ingénieurs qui ont participé aux conférences Macy sur la cybernétique à la fin des années quarante et au début des années cinquante. La cybernétique se voulait une science universelle capable d’unifier toutes les disciplines – une nouvelle adaptation de l’encyclopédisme du XVIIIe siècle, selon Gilbert Simondon[8]. La cybernétique utilise le concept de rétroaction pour définir le fonctionnement d’une nouvelle « machine cybernétique » distincte des « machines mécaniques » du XVIIe siècle. Wiener affirmait dans son livre fondateur de 1948 que la cybernétique avait surmonté l’opposition entre mécanisme et vitalisme représentée par Newton et Bergson, parce que les machines cybernétiques étaient basées sur une nouvelle forme de causalité non linéaire, ou récursivité, au lieu d’une causalité linéaire fragile et inefficace – fragile parce qu’elle ne sait pas comment réguler son propre mode de fonctionnement. Imaginez une montre mécanique : lorsque l’un des engrenages tombe en panne, c’est toute la montre qui s’arrête. Avec ce type de mécanisme linéaire, aucune augmentation exponentielle de la vitesse de raisonnement ne peut se produire sans une mise à niveau radicale du matériel.

Si l’opposition entre mécanisme et organisme caractérise un grand débat de la philosophie moderne, déterminant la direction de son développement, alors le débat persiste aujourd’hui, alors que tant de déclarations discréditant l’IA et ChatGPT supposent que les machines sont uniquement mécanistes et donc incapables de comprendre le sens sémantique. Il serait tout aussi erroné de prétendre que les machines ne sont qu’une imitation ratée de la compréhension humaine lorsqu’il s’agit de sens sémantique. Le philosophe et spécialiste des sciences cognitives Brian Cantwell Smith a vivement critiqué cette pensée anthropomorphique, défendant une intentionnalité machinique. Pour lui, même si l’on ne trouve pas d’intentionnalité humaine dans une machine, celle-ci n’en demeure pas moins une forme d’intentionnalité ; elle est sémantique, même si ce n’est pas au sens du langage humain[9]. Une telle séparation entre sémantique anthropomorphique et sémantique machinique est fondamentale pour repenser nos relations avec les machines, mais ce n’est qu’un premier pas.

L’argument de Searle ignore fondamentalement la forme récursive du calcul effectué par les machines d’aujourd’hui. On pourrait objecter que l’informatique ne devrait pas être confondue avec la cybernétique, car cette dernière est une science trop globale. Cependant, on peut aussi penser à la fonction récursive de Gödel et à son équivalence avec la machine de Turing et le lambda calcul d’Alonzo Church (une histoire bien connue dans l’histoire de l’informatique). Le terme « récursivité » n’appartient pas seulement à la cybernétique, mais aussi à la pensée post-mécaniste. L’avènement de la cybernétique n’a fait qu’annoncer la possibilité de réaliser cette pensée récursive dans des machines cybernétiques.

L’« intelligence » que l’on trouve aujourd’hui dans les machines est une forme d’opération réflexive, comme l’ont fait remarquer à juste titre Gotthard Günther et Gilbert Simondon. Pour Günther, la cybernétique est la réalisation de la logique de Hegel, tandis que pour Simondon, ce n’est que dans l’élaboration de la Critique de la faculté de juger que Kant a abordé la cybernétique[10]. La « pensée réflexive » est généralement associée aux êtres humains et non aux machines, car les machines ne font qu’exécuter des instructions sans réfléchir aux instructions elles-mêmes. Mais depuis l’introduction de la cybernétique dans les années 1940, le terme peut également décrire le mécanisme de rétroaction des machines. La pensée réflexive des machines a un pouvoir étonnant sur les êtres humains qui ne sont pas prêts à accepter son existence, même en tant que forme préliminaire et basique de réflexion – étant purement formelle et donc insuffisante pour traiter du contenu. On comprend ici en quoi ChatGPT peut n’être « pas particulièrement innovant » et n’avoir « rien de révolutionnaire » pour des informaticiens comme Yann LeCun[11]. Ce n’est qu’en traitant le contenu que les machines pourront aller vers ce que l’on a appelé la singularité technologique. Jusqu’à présent, la singularité reste un mythe – un mythe trompeur et aussi nuisible lorsqu’il est présenté comme un futur proche. Même si l’on associe à la singularité une signification théologique ou eschatologique, cela n’apporte rien à la compréhension de l’intelligence artificielle ou de son avenir.

Ce sont les machines récursives, et non les machines linéaires, qui permettent de comprendre le développement et l’évolution de l’intelligence artificielle. Comment les êtres humains vont-ils se confronter à ce nouveau type de machine ? Simondon a soulevé une question similaire en posant la question suivante : lorsque la technologie deviendra réflexive, quel sera le rôle de la philosophie ? Brian Cantwell Smith a soutenu que l’IA se limite à la capacité d’évaluation et non de jugement, mais il est difficile de dire combien de temps encore une telle distinction pourra être maintenue[12]. Peut-être que trop d’efforts intellectuels ont été perdus à faire des distinctions entre les machines et les humains.

Les êtres humains n’ont pas été bouleversés lorsque les animaux domestiqués, tels que les chevaux et les vaches, les ont remplacés en tant que fournisseurs d’énergie. Ils se sont au contraire réjouis d’être soulagés d’un travail répétitif et fastidieux. Il en a été de même lorsque les machines à vapeur ont remplacé les animaux ; elles étaient encore plus efficaces et nécessitaient encore moins d’attention de la part de l’homme. Simondon, dans son ouvrage de 1958 intitulé Du Mode d’existence des objets techniques, a observé à juste titre que le remplacement des machines thermodynamiques par des machines à information marque un moment critique : le déplacement de l’homme du centre de production. Avant l’ère industrielle, les artisans étaient capables de créer un milieu associé dans lequel le corps et l’intelligence de l’artisan compensaient le manque d’autonomie de leurs simples outils. À l’ère des machines à information, ou machines cybernétiques, la machine elle-même devient l’organisateur de l’information et l’homme n’est plus au centre, même s’il se considère toujours comme le commandant des machines et l’organisateur de l’information. C’est à ce moment que l’humain souffre de ses propres croyances stéréotypées sur les machines : il s’identifie faussement comme le centre et, ce faisant, il est confronté à une frustration constante et à une recherche paniquée d’identité.

La réalité qui réside dans la machine est aliénée par rapport à la réalité dans laquelle l’homme opère. Le processus inévitable de l’évolution technologique est guidé par l’introduction d’une causalité non linéaire, qui permet aux machines de faire face à la contingence. Une machine apprenante est capable de discerner des événements contingents tels que le bruit et l’échec. Elle peut distinguer les intrants non organisés des intrants nécessaires. En interprétant les événements contingents, le machine learning améliore son modèle de prise de décision. Mais même dans ce cas, la machine a besoin d’humains pour distinguer les bonnes décisions des mauvaises afin de continuer à s’améliorer. Dans les pays en développement, un nouveau type de main-d’œuvre bon marché emploie des humains pour indiquer aux machines si les résultats sont corrects, qu’il s’agisse de scans de reconnaissance faciale ou de réponses à ChatGPT. Cette nouvelle forme de travail, qui exploite les travailleurs qui travaillent de manière invisible derrière les machines avec lesquelles nous interagissons, est souvent négligée par les critiques très générales du capitalisme qui déplorent l’insuffisance de l’automatisation. C’est la faiblesse de la critique marxienne actuelle de la technologie.

Simondon a soulevé une question clé dans Du Mode d’existence des objets techniques : Lorsque l’homme cesse d’être l’organisateur de l’information, quel rôle peut-il jouer ? L’homme peut-il être libéré du travail ? Comme le soupçonnait Hannah Arendt dans Condition de l’homme moderne, publié la même année que le livre de Simondon, une telle libération ne mène qu’au consumérisme, laissant l’artiste comme le « dernier homme » capable de créer[13]. Le consumérisme devient alors la limite de l’action humaine. Arendt considère les machines du point de vue de la réalité humaine, comme remplaçant l’Homo faber, tandis que Simondon montre qu’une incapacité à traiter et à intégrer la réalité technique des machines favorisera un antagonisme malheureux entre l’homme et la machine, la culture et la technique. Cet antagonisme n’est pas seulement la source de la peur. Il repose également sur une compréhension très problématique de la technologie, façonnée par la propagande industrielle et le consumérisme. C’est à partir de cette négativité que s’est développé un humanisme primitiviste, identifiant l’amour comme le dernier recours de l’homme.

Plus de soixante ans se sont écoulés depuis que Simondon a soulevé ces questions, et elles n’ont toujours pas été résolues. Pire encore, elles ont été occultées par l’optimisme technologique et le pessimisme culturel, le premier favorisant une accélération incessante et le second faisant office de psychothérapie. Ces deux tendances découlent d’une compréhension anthropomorphique des machines, selon laquelle elles sont censées imiter les êtres humains. (Simondon a violemment critiqué la cybernétique pour avoir adopté ce point de vue, même si cela n’était pas entièrement justifié). Aujourd’hui, l’expression la plus ironique de cette conception du mimétisme se trouve dans le domaine de l’art, dans les tentatives de prouver qu’une machine peut faire le travail d’un Bach ou d’un Picasso. D’une part, l’homme paniqué demande sans cesse quels types d’emplois peuvent éviter d’être remplacés par des machines ; d’autre part, l’industrie technologique s’efforce consciemment de remplacer l’intervention humaine par l’automatisation des machines. Les humains vivent dans la prophétie autoréalisatrice de remplacement de l’industrie. En effet, l’industrie reproduit constamment le discours du remplacement en annonçant la fin de tel ou tel emploi comme si une révolution était arrivée, alors que la structure sociale et notre imaginaire social restent inchangés.

Le discours de remplacement ne s’est pas transformé en discours de libération dans les sociétés capitalistes ni dans les sociétés dites communistes. Pour être juste, certains accélérationnistes en sont conscients et ont cherché à faire revivre la vision de Marx d’une automatisation totale. Si les cours de physique du secondaire étaient plus populaires, nous aurions un concept plus nuancé de l’accélération, car l’accélération ne signifie pas une augmentation de la vitesse, mais plutôt une augmentation de la vélocité. Au lieu d’élaborer une vision de l’avenir dans laquelle l’intelligence artificielle servirait de prothèse, le discours dominant la traite simplement comme un défi à l’intelligence humaine et comme un substitut au travail intellectuel. Les humains d’aujourd’hui ne rêvent pas. Si le rêve du vol a conduit à l’invention de l’avion, les cauchemars des machines s’intensifient aujourd’hui. En définitive, le techno-optimisme (sous la forme du transhumanisme) et le pessimisme culturel se rejoignent dans la projection d’une fin apocalyptique.

La créativité humaine doit prendre une direction radicalement différente et élever les relations homme-machine au-dessus de la théorie économique du remplacement et des fantasmes de l’interactivité. Elle doit s’orienter vers une analyse existentielle. La nature prothétique de la technologie doit être affirmée au-delà de sa fonctionnalité, car depuis le début de l’humanité, l’accès à la vérité a toujours dépendu de l’invention et de l’utilisation d’outils. Ce fait reste invisible pour beaucoup, ce qui fait que le conflit entre l’évolution de la machine et l’existence humaine semble provenir d’une idéologie profondément enracinée dans la culture.

Nous vivons dans diverses boucles de rétroaction positive représentées par la culture. Depuis le début de la société industrielle moderne, le corps humain a été subordonné à des rythmes répétitifs et, par conséquent, l’esprit humain a été subsumé par les prophéties de l’industrie. Qu’il s’agisse du rêve américain ou du rêve chinois, l’énorme potentiel humain a été supprimé au profit d’une idéologie consumériste. Dans le passé, la philosophie avait pour mission de limiter l’orgueil démesuré des machines et de libérer les sujets humains des boucles de rétroaction au nom de la vérité. Aujourd’hui, les philosophes de la technologie sont plutôt soucieux d’affirmer ces boucles de rétroaction comme le chemin inévitable de la civilisation. L’homme reconnaît désormais la centralité de la technique en voulant résoudre tous les problèmes comme s’il s’agissait de problèmes techniques. La vitesse et l’efficacité régissent l’ensemble de la société alors qu’elles ne régissaient autrefois que les disciplines techniques. Le désir des éducateurs de réaliser un changement paradigmatique dans quelques années discrédite toute réflexion fondamentale sur la question de la technologie, et nous nous retrouvons à nouveau dans une boucle de rétroaction. Par conséquent, les universités continuent à produire des talents pour l’industrie technologique, et ces talents continuent à développer des algorithmes plus efficaces pour exploiter la vie privée des utilisateurs et manipuler la façon dont ils consomment. Pour les universités, il devrait être plus urgent de traiter ces questions que de réfléchir à l’interdiction de ChatGPT.

L’être humain peut-il échapper à cette boucle de rétroaction positive de la prophétie autoréalisatrice si profondément ancrée dans la culture contemporaine ? En 1971, Gregory Bateson a décrit une boucle de rétroaction qui piège les alcooliques : un verre de bière ne me tuera pas ; d’accord, j’ai déjà commencé, un deuxième devrait suffire ; bon, il y en a déjà deux, pourquoi pas trois ? Un alcoolique, s’il a de la chance, peut sortir de cette boucle de rétroaction positive en « touchant le fond » – en survivant à une maladie mortelle ou à un accident de voiture, par exemple[14]. Ces survivants chanceux développent alors une intimité avec le divin. Les humains, les alcooliques modernes, avec toute leur intelligence et leur créativité collectives, peuvent-ils échapper à ce destin de toucher le fond ? En d’autres termes, l’être humain peut-il prendre un virage radical et pousser la créativité dans une autre direction ?

Cette possibilité n’est-elle pas précisément offerte par les machines intelligentes d’aujourd’hui ? En tant que prothèses au lieu de suivre des modèles par cœur, les machines peuvent libérer l’homme de la répétition et nous aider à réaliser le potentiel humain. La manière d’acquérir cette capacité de transformation est essentiellement notre préoccupation aujourd’hui, et non le débat sur la question de savoir si une machine peut penser, qui n’est qu’une expression de la crise existentielle et de l’illusion transcendantale. Peut-être que de nouvelles prémisses concernant les relations homme-machine peuvent libérer notre imagination. En voici trois, mais on peut certainement en ajouter d’autres :

1. Au lieu de suspendre le développement de l’IA, suspendre les stéréotypes anthropomorphiques des machines et développer une culture adéquate de la prothèse. La technologie devrait être utilisée pour réaliser le potentiel de ses utilisateurs (nous devrons ici entamer un dialogue avec la théorie des capacités d’Amartya Sen) au lieu d’être leur concurrent ou de les réduire à des modèles de consommation.

2. Au lieu de mystifier les machines et l’humanité, il faut comprendre notre réalité technique actuelle et sa relation avec les diverses réalités humaines, afin que cette réalité technique puisse être intégrée avec elles pour maintenir et reproduire la biodiversité, la noodiversité et la technodiversité[15].

3. Au lieu de répéter la vision apocalyptique de l’histoire (une vision exprimée, dans sa forme la plus laïque, dans la fin de l’histoire de Kojève et Fukuyama), libérer la raison de son chemin fatal vers une fin apocalyptique. Cette libération ouvrira un champ qui nous permettra d’expérimenter des manières éthiques de vivre avec les machines et les autres non-humains.

Aucune invention n’arrive sans contraintes et sans problèmes. Bien que ces contraintes soient plus conceptuelles que techniques, ignorer le conceptuel est précisément ce qui permet au mal de se développer, en tant que résultat d’une perversion dans laquelle la forme dépasse le fond[16]. Ce n’est qu’en nous détachant des préjugés culturels et de la prophétie autoréalisatrice de l’industrie technologique que nous pourrons développer une meilleure compréhension des possibilités de l’avenir, qui ne peuvent pas être basées uniquement sur l’analyse des données et l’extraction de modèles. Il est fort probable qu’avant d’en arriver là, les prophètes industriels de notre époque auront déjà compris que les machines peuvent prédire l’avenir mieux qu’eux.

Yuk Hui

Retrouvez l’article original sur https://www.e-flux.com/journal/137/544816/chatgpt-or-the-eschatology-of-machines/

[1] « Cette conception occidentale de l’histoire, qui implique une direction irréversible vers un but futur, n’est pas simplement occidentale. Il s’agit essentiellement d’une hypothèse hébraïque et chrétienne selon laquelle l’histoire est orientée vers un but ultime et gouvernée par la providence d’une intuition et d’une volonté suprêmes – selon les termes de Hegel, par l’esprit ou la raison en tant qu’« essence absolument puissante » ». Karl Löwith, Meaning in History (University of Chicago Press, 1949), p. 54.

[2] Carl Schmitt, Théologie politique, Paris, Gallimard, 1988.

[3] Hans Blumenberg, « Progress Exposed as Fate », chap. 3 de la partie 1, dans The Legitimacy of the Modern Age, MIT Press, 1985.

[4] John. R. Searle, « Minds, Brains, and Programs », Behavioral and Brain Sciences 3, no. 3, 1980, p. 418.

[5] Noam Chomsky, Ian Roberts et Jeffrey Watumull, « The False Promise of ChatGPT », New York Times, 8 mars 2023 : https://www.nytimes.com/2023/03/08/opinion/noam-chomsky-chatgpt-ai.html

[6] Yuk Hui, Recursivity and Contingency, Rowman and Littlefield, 2019.

[7] Voir Yuk Hui, « Philosophy after Automation », Philosophy Today 65, no 2, 2021.

[8] Gilbert Simondon, « Technique apprise par l’enfant et technique pensée par l’adulte », chap. 2 de la partie 2, in Du mode d’existence des objets techniques (1958).

[9] « De nombreuses personnes ont soutenu que la sémantique des systèmes informatiques est intrinsèquement dérivée ou attribuée – c’est-à-dire du type de celle des livres et des signes, dans le sens où elle est attribuée par des observateurs ou des utilisateurs extérieurs – par opposition à la sémantique de la pensée et du langage humains, qui, elle, est supposée être originale ou authentique. Je doute de l’utilité ultime (et de la netteté) de cette distinction, ainsi que de son applicabilité aux ordinateurs ». Brian Cantwell Smith, On the Origin of Objects, MIT Press, 1996, p. 10. Pour une discussion approfondie des travaux de Smith, voir Yuk Hui, « Digital Objects and Ontologies », chap. 2 dans On the Existence of Digital Objects, University of Minnesota Press, 2016.

[10] Gotthard Günther, Das Bewusstsein der Maschinen: eine Metaphysik der Kybernetik, Agis-Verlag, 1957 ; Gilbert Simondon, Sur la philosophie, PUF, 2016, p. 180.

[11] Cité dans Tiernan Ray, « ChatGPT Is ‘Not Particularly Innovative,’ and ‘Nothing Revolutionary,’ Says Meta’s Chief AI Scientist », ZDNET, 23 janvier 2023 : https://www.zdnet.com/article/chatgpt-is-not-particularly-innovative-and-nothing-revolutionary-says-metas-chief-ai-scientist/

[12] Brian Cantwell Smith, The Promise of Artificial Intelligence : Reckoning and Judgment, MIT Press, 2019. J’ai approfondi l’argument de Smith dans le chapitre 3 de Art and Cosmotechnics, e-flux et University of Minnesota Press, 2021.

[13] Hannah Arendt, Condition de l’homme moderne, Paris, Calmann-Lévy, 1961.

[14] Gregory Bateson, « The Cybernetics of ‘Self’ : A Theory of Alcoholism », dans Steps to an Ecology of Mind, Jason Aronson, 1987.

[15] Voir Yuk Hui, « Pour une pensée planétaire », revue e-flux, no 114, décembre 2020 : https://www.e-flux.com/journal/114/366703/for-a-planetary-thinking/

[16] Voir la question du mal dans F. W. J. Schelling, Recherches philosophiques sur l’essence de la liberté humaine et les sujets qui s’y rattachent, Paris, Payot, 1977.